使用Cloudflare AI免费托管Host LLama 2。

在本指南中,我们将探讨如何使用Cloudflare Workers免费部署和托管强大的语言模型LLaMA 2。

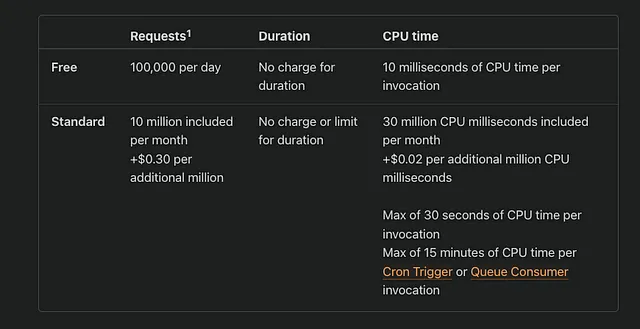

LLMs(大规模语言模型)和人工智能技术正在快速发展,而且有了Cloudflare慷慨的定价模型,你完全有条件开始开发自己的人工智能应用程序。

遵循以下步骤设置您的应用程序:

1. 创建一个 Cloudflare 账户

开始注册或登录您的Cloudflare账户。

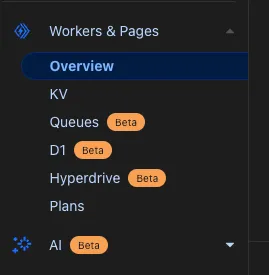

2. 导航至工人和页面

在您的控制台中,找到“工作人员和页面”部分,开始设置您的新应用程序。

3. 创建您的应用

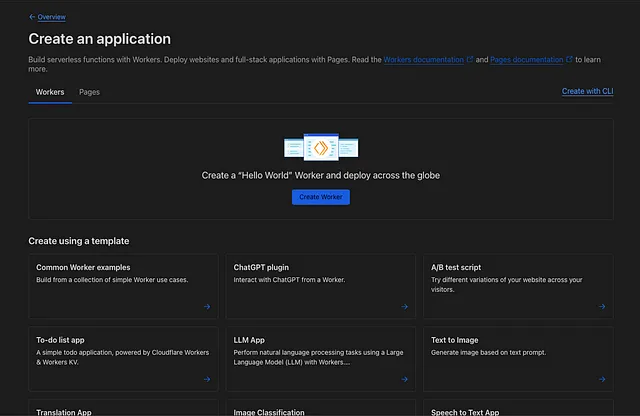

点击“创建应用程序”按钮来启动设置流程。

4. 创建工人

从“Workers”选项卡下的模板中选择“LLM App”。这个选择将作为您的应用程序的基础,使JavaScript能够在Cloudflare的服务器上执行。选择LLM App模板将为运行此类应用程序提供所需的必要包的起点。

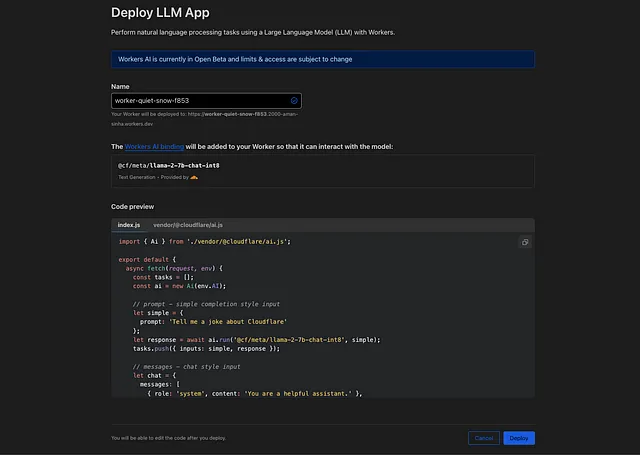

5. 部署您的工作人员

创建工作者后,单击“部署”。不用担心,您以后可以根据需要更新工作者的代码。

好耶!我们的工作程序已经上线了,按照以下的格式发送请求就可以看到奇迹发生了。请将URL替换为您的工作程序URL。

curl --location 'https://worker-white-tooth-29e9.2000-aman-sinha.workers.dev/' \

--header 'Content-Type: application/json' \

--data '{

"prompt": "say a joke"

}'

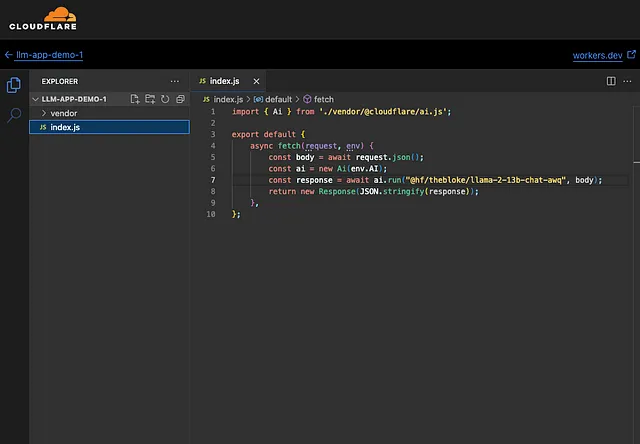

6. 编辑您的工作者代码

现在,是时候自定义您的工作程序了。点击“编辑代码”开始编码。最初,您的工作程序已启动运行。

在index.js中编辑,将下面的内容添加进去。

最终项目如下所示。

点击“保存并部署”

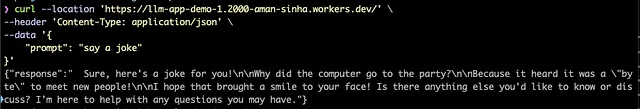

我们的法学硕士(LLM)项目已经开始运转,并且接受我们的请求和提示。

让我们尝试通过以下请求来获取一个笑话。将URL更改为您的worker的URL,以使其生效。

curl --location 'https://worker-white-tooth-29e9.2000-aman-sinha.workers.dev/' \

--header 'Content-Type: application/json' \

--data '{

"prompt": "say a joke"

}'

干得好。我们的应用已经上线,现在我们可以开始使用Llama2了。

您可以在Cloudflare AI上查看各种可用模型。

尝试各种模型,看哪个最适合您的使用情况,然后继续前进。

我深度参与人工智能和法学硕士课程。欢迎在Medium上关注我以获取更多见解。

随时打招呼或通过Twitter和LinkedIn与我联系。