Sure, here's the translation in simplified Chinese while keeping the HTML structure:

```html

如何工作

```

Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html

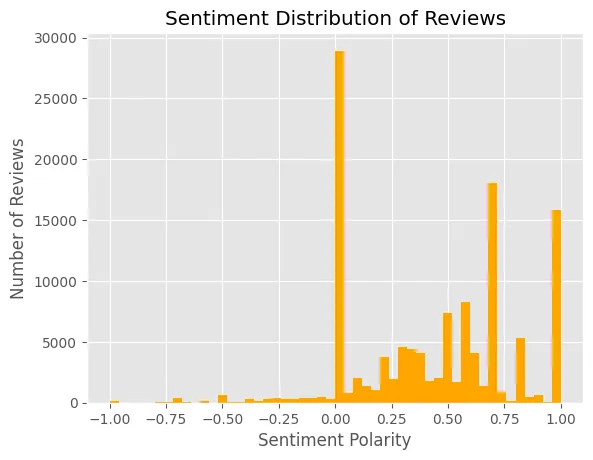

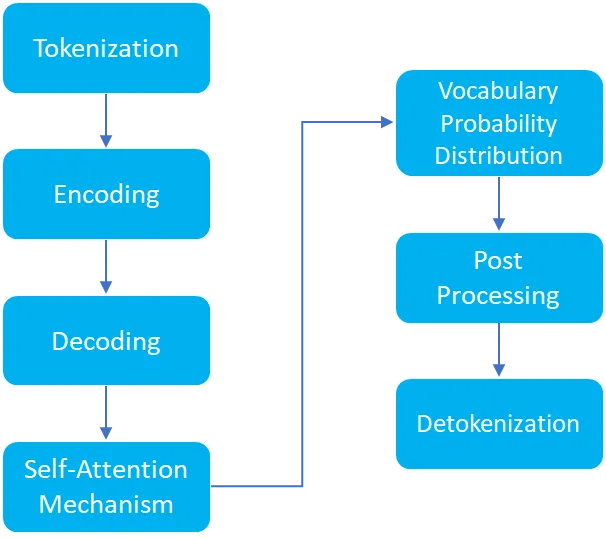

我们对大型语言模型生成响应的方式感到惊讶。LLM能够生成如此类人的响应,并且被优化以执行各种任务,例如文本生成,翻译,图像生成以及对用户查询的响应。在本文中,我将讨论ChatGPT背后的机制,它基于Transformer架构和自注意力机制工作。

```Sure, here's the translated text in simplified Chinese: 当用户向ChatGPT提出问题并从ChatGPT获得回复时,各种类型的处理都会发生。让我们讨论一下其中的逐步机制。

- Sure, here's the translation in simplified Chinese, while keeping the HTML structure:

```html

分词化 — 模型将用户查询分解为较小、可管理的片段,称为标记。这些标记可以是单词、字符或子词。这个分词化过程至关重要,因为它将人类可读的文本转换为机器学习模型可以理解和操作的格式。

``` - Sure, here's the translated text: ``` 编码 — 模型中的每个标记都经过令牌化后,会经过几个编码器层次进行发送。在此阶段,每个标记都会转换为高维向量。这些向量捕捉了语法角色和语义含义;这些不仅仅是标记的数值表示。由于这种编码,模型可以理解上下文、细微差别以及各种问题组件之间的联系。 ```

- Sure, here's the translated text in simplified Chinese:

```html

解码 — 解码器的上下文基础建立在编码器生成的向量之上。响应令牌以自回归方式逐个由解码器层生成。这意味着生成的每个新令牌都依赖于编码器对完整输入查询的理解,以及输出中之前的令牌。

``` - Sure, here's the translation: 自注意机制-自注意机制是Transformer架构最创新的特性之一。该方法使模型能够对输入查询的不同部分和解码阶段先前创建的标记赋予不同的权重。这种加权注意在维护生成文本的叙事连贯性和与查询的上下文相关性方面起着至关重要的作用。

- Sure, here's the translated text in simplified Chinese while keeping the HTML structure:

```html

```词汇概率分布 — 该模型计算出对每个要生成的新标记的整个词汇表的概率分布。即使通常会选择具有最高可能性的标记作为下一个要生成的标记,也可以利用先进的方法添加一定程度的原创性和随机性到输出中。

- Sure, here's the translated text in simplified Chinese, keeping the HTML structure:

```html

迭代式标记生成 — 解码器通过解码、自注意机制和词汇概率分布步骤进行迭代循环,以持续生成新的标记。此过程会持续进行直到达到预定的终点。这可能发生在用尽所有标记时,当遇到特定的句子结束标记,或在其他情况下。

``` - Sure, here's the translation in simplified Chinese: 解标记化和最终输出生成 — 这是一个后处理步骤,一旦解码器为响应生成了完整的标记集,下一步是将这些标记转换回自然语言文本。最后,解标记化的文本被打包成对用户查询的全面响应。

Sure, here's the translated text in simplified Chinese, while maintaining the HTML structure: ```html

我们讨论了用户查询的处理和输出生成。用户查询通过一系列步骤进行处理,然后通过解码和自注意机制生成输出。ChatGPT使用自回归机制逐个生成标记,这就是它向用户查询生成输出的方式。

```