什么是随机鹦鹉?了解ChatGPT和其他大型语言模型

随机鹦鹉。这是您可能不熟悉的一个术语,但它是人工智能领域内一次变革性讨论的核心。

在颇具影响力的论文《论随机鹦鹉的危险:语言模型可以太大吗?》中,这个概念将诸如ChatGPT之类的大型语言模型(LLM)与“随机鹦鹉”进行比较。

考虑将这些语言模型看作是鹦鹉模仿单词而不曾真正掌握其真正的本质。这些单词可能是真实的,然而,就像我们的LLM一样,鹦鹉并没有真正理解它们的含义。这只是一种简单的复制。

“随机的”本质上意味着随机的。

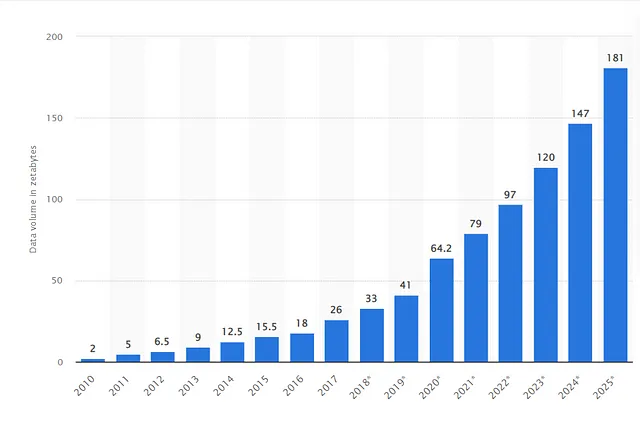

让我们更详细地解释一下这个术语。“随机”本质上意味着随机。这指的是这些模型在生成响应时固有的随机性。你可能会问,为什么是随机的呢?这源于LLM在大量数据上的训练方式,它们的响应是基于学习到的模式生成的,而不是来自对语言的有意识的理解。

当语言模型构建一个回复时,它并非凭借着对词语和短语含义的清晰理解进行挑选。它无法理解与这些词汇相关联的情感、社会规范或文化意义。它仅仅是基于从其训练数据中学习到的模式串联起来的文字,这使得它能够产生看似有认知和思考的文本。

现在,考虑到这一点,当这些“随机鹦鹉”有时产生不正确甚至冒犯的回应时,我们不能感到震惊。

记住,它们不能理解它们所模仿的单词。它们基于模式生成语言,有时,这些模式会导致产生的结果远非完美或适当。

这不是借口,而是它们设计中的一个根本方面,我们在继续开发和部署这些强大工具时必须面对的挑战之一。

总结:

- “随机鹦鹉”是一篇论文“The Dangers of Stochastic Parrots: Can Language Models Be Too Big?”中描述类似ChatGPT的大型语言模型(LLMs)的术语。

- 与鹦鹉相比,这些模型模仿人类语言,但却不理解意义或语境。

- “Stochastic” 意味着这些模型的响应是随机的,是来自于对数据中已学习的模式而非语言的有意识理解。

- 模型缺乏真正的理解可能会导致不正确甚至冒犯的输出,突显了其设计和使用的挑战。