LLM作为操作系统?MemGPT是什么?

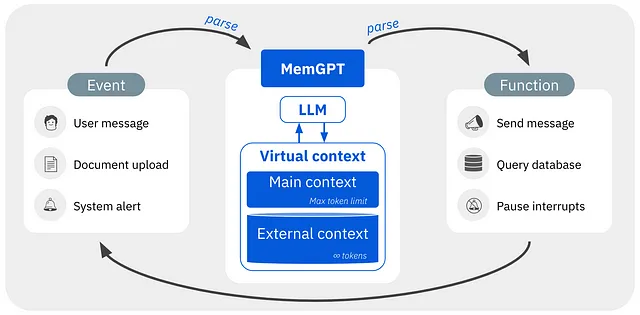

虽然大型语言模型(LLMs)已经革新了人工智能,但它们在扩展对话和文档分析等任务中的使用受到了受限的上下文窗口的限制。我们提出了虚拟上下文管理,这是一种受传统操作系统的分层存储器结构启发的方法,它允许在受限上下文窗口之外使用上下文能力。通过迅速在不同内存层之间传输数据而产生的庞大内存资源的出现,例如从弱内存到强内存等等。我们使用这种方法引入了MemGPT(Memory-GPT)系统,该系统通过智能地管理多个内存层来在LLM的有限上下文窗口内提供更多的上下文,并利用中断来控制用户的控制流。

MemGPT可以通过使用记忆层次结构、操作系统功能和基于事件的控制流来处理无界上下文。我们在两个领域对MemGPT进行了测试——文档分析领域,标准文本文件的大小很快会超过当代LLM的输入容量,以及对话代理领域,受限于小型对话窗口的LLM缺乏上下文意识、个性一致性和长期记忆,在长时间对话中现有LLM的性能受到严重限制。MemGPT能够在这两种情况下克服有限上下文的缺点,并超越当前基于LLM的方法。

描述如何将MemGPT这种受操作系统启发的LLM系统应用到实践中,以训练LLM来管理自己的内存以实现无限上下文。主上下文(相当于主内存/物理内存/RAM)和外部上下文(类似于磁盘内存/磁盘存储)是组成MemGPT多级内存架构的两种基本内存类型。主上下文中的任何对象都被视为在上下文中,并且在推理过程中,LLM处理器可以访问这些对象。主上下文是当前语言模型中典型的固定上下文窗口。存储在LLM固定上下文窗口之外的任何数据都被称为外部上下文。

在MemGPT中,LLM输入被称为系统的主要上下文,因为它们受限于允许的最大输入标记数。LLM基于对话代理的大部分主要上下文标记通常用于存储“系统消息”或“预提示”,以指定与系统的互动性质,其余的标记用于存储讨论材料。

根据使用情况,预准考提示可以从简单的入门指南(如“您是一个乐于助人的助手。”)到由数千个标记组成的复杂指令(如包括角色背景和示例对话的虚构角色卡片)。这个预准考提示是系统采用各种不同人物形象的主要方法,并且不需要对基础模型进行精细调整。大型预准考提示在LLM用于完成需要详细指示和/或具有多个上下文示例的复杂任务时尤为常见,这些任务超出了对话代理所需的指示。

数据集

在多会话聊天(MSC)数据集上,该数据集由人类标注者创建的多会话聊天记录组成,标注者在每个会话期间都被期望扮演一个一致的角色。我们对MemGPT和我们的固定上下文基线进行测试。每个MSC多会话对话包含总共五个会话,每个会话大约有十几条消息。

MemGPT 用于文档分析

由于当前转换模型的限制上下文窗口,文档分析也面临着困难。例如,最先进的开源模型 Llama 2 的最大输入令牌仅为4k,而 OpenAI 的(封闭的)GPT 模型,该模型驱动其著名的 ChatGPT 消费者聊天机器人应用程序,最多只能输入32k 个令牌。史蒂芬·金(Stephen King)的畅销书《闪灵》大约有15万个词,或者大约有20万个令牌(根据使用的特定分词器而有所不同),而像年度报告(SEC 第10-K 表格)之类的法律或金融文件很容易超过百万个令牌。Anthropic 已发布了(封闭的)可处理高达10万个令牌的模型,但许多文件的长度很容易超过这个限制。

MemGPT的限制

OpenAI GPT-4模型特别针对函数调用进行了优化。OpenAI的API描述表明,当使用经过函数微调的模型时,所提供的函数架构会通过微调过程转化为模型训练中理解的系统消息。然而,OpenAI模型的内部工作方式是专有的,未公开披露。我们发现,经过函数微调的GPT-4模型在MemGPT函数集上很少出现语法或语义错误,而经过GPT-3.5微调的模型则经常生成不正确的函数调用或尝试错误地使用函数。经过函数调用微调的GPT模型仍然需要一个解析器来验证输出是否是有效的函数语法。

此外,还发现最广泛使用的Llama 2 70B型号版本(即使那些已经针对函数调用进行了优化)经常会产生错误的函数调用,甚至会在指定的模式之外产生幻觉函数。

结论

MemGPT是一种用于管理大型语言模型受限上下文窗口的独特LLM系统。它受到操作系统的影响。通过创建与传统操作系统类似的内存层次结构和控制流,MemGPT给人一种LLM上下文资源更加丰富的外观。这种受操作系统启发的方法已在文档分析和对话代理两个领域进行了测试,这两个领域的现有LLM性能受到上下文长度的限制。通过高效地将重要上下文从内存中分页进出,MemGPT可能能够处理长度超出当前LLM上下文限制的文档分析中的长文本。

MemGPT使得交流代理人能够在长时间的对话中保持长期记忆、一致性和适应性。MemGPT表明,即使在固定上下文长度的情况下,操作系统中的中断和分层内存管理等功能也能释放出大型语言模型的潜力。