GPT-5的完整训练已经上线。

我们可以期待它在11月发布,可能是传奇ChatGPT推出的二周年纪念日。

在相似的时间框架内,我们还将推出Gemini 2 Ultra,LLaMA-3,Claude-3,Mistral-2和许多其他突破性的型号。

(谷歌的Gemini似乎已经为GPT-4 Turbo带来了激烈的竞争)

几乎可以确定GPT-5将会逐步发布,在模型训练过程中这些将是中间的检查点。

实际的培训可能需要3个月,额外的6个月用于安全测试。

將GPT-5放入透視中

首先让我们来看一下GPT-4规格:

GPT4模型估计

规模:GPT-4拥有超过1.8万亿个参数,分布在120个层次上,比GPT-3大10倍以上。

混合专家(MoE):OpenAI 在其模型中利用了 16 个专家,每个专家有约 1110 亿个 MLP 参数。

数据集:GPT-4 使用约13T个令牌进行训练,包括基于文本和基于代码的数据,还包括一些来自 ScaleAI 和内部的精调数据。

数据集合: 训练数据包括CommonCrawl和RefinedWeb,共计13T词。有猜测表明还可能包括额外来源如Twitter、Reddit、YouTube和大量的教科书。

培训成本:考虑到所需的计算能力和培训时间,GPT-4的培训费用约为6300万美元。

推理成本:由于需要更大的集群和更低的利用率,GPT-4的成本是175B参数的Davinci的3倍。

推理架构:推理在一个由128个GPU组成的集群上运行,使用8路张量并行和16路管道并行。

Vision Multi-Modal:GPT-4包含一个视觉编码器,用于自主代理阅读网页、转录图像和视频。在此基础上添加了更多的参数,并使用另外约2万亿个标记进行了优化调整。

现在,GPT-5的参数可能是GPT-4的10倍,这是一个巨大的数量!这意味着更大的嵌入维度,更多的层次和两倍的专家数量。

较大的嵌入维度意味着更细致的特征区分,而加倍层数则使模型能够进行更深层次的模式识别。

GPT-5将在推理方面大有提升,它会在解决问题之前列出推理步骤,并对每个推理步骤进行内部或外部检查。

验证推理步骤的方法,并进行最多10,000次的抽样将在代码生成和数学方面带来明显更好的结果。

结果监督和过程监督奖励模型的比较,通过它们在搜索许多测试解决方案的能力进行评估。

抽样对模型进行数千次计算,并选择具有最高评级推理步骤的答案,这样可以使数学表现提升一倍,而且这不仅仅适用于数学,在STEM领域中也能产生显著的成果。

GPT-5将会在数据量、质量和多样性方面接受更多的训练。

这包括大量的文本、图像、音频和视频数据。还包括多语言数据和推理数据。

这意味着多模态将在今年大大改善,而LLM推理将起飞。

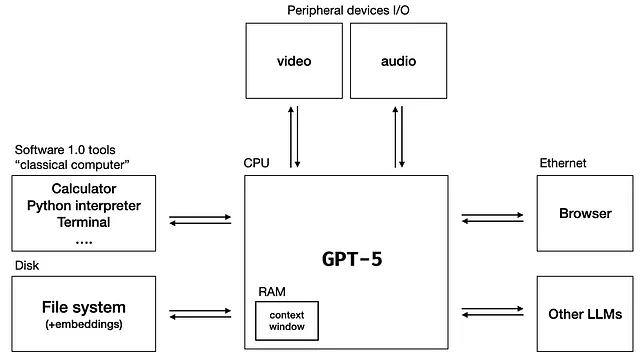

这将使GPT-5变得更加主体性,就像将LLM用作操作系统一样。

尽管在2024年发布的LLM不会发生真正疯狂/颠覆现实的事情,比如LLM发明新科学、治愈疾病,制造戴森球或生物武器。

2024年将会有更加清晰、商业适用的模型版本,这些模型相较于现有的模型将有显著提升。人们将会惊讶地发现这些模型的表现有多好。

没有人真正知道新的模型会是怎样的。

在人工智能历史中最大的主题是,它充满了意外。

每次你以为你知道些什么东西时,把它放大10倍,结果你会发现自己一无所知。作为人类这个物种,我们真正地共同探索着这一切。

尽管如此,所有在LLMs和AI方面的集体进展都是迈向AGI的一大步。🚀

Sources:- GPT-5:迄今为止您需要了解的一切- 可视化大型语言模型的大小- GPT-4 架构、数据集、成本等等的泄漏- LLM 操作系统- 让我们一步一步验证论文